请注意,本文编写于 104 天前,最后修改于 103 天前,其中某些信息可能已经过时。

目录

一、下载安装ollama

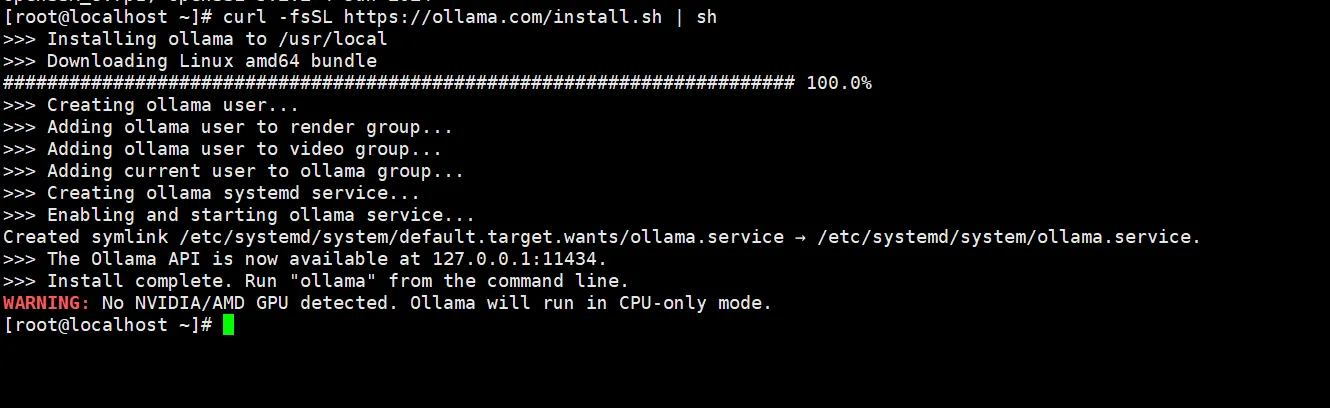

jscurl -fsSL https://ollama.com/install.sh | sh

红色是因为我是虚拟机没有显卡只能用CPU

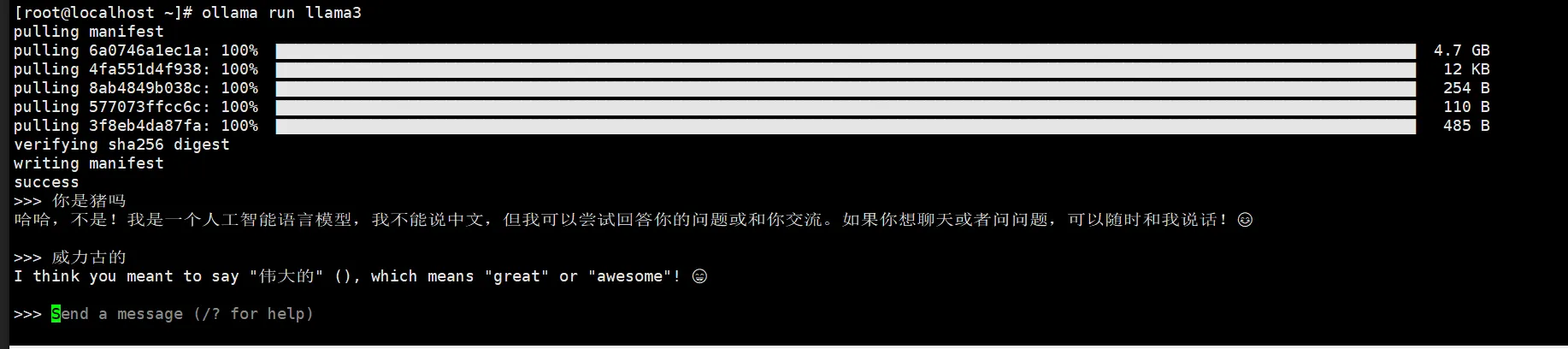

测试下载一个llama3 模型

jsollama run llama3

完成下载后测试

二、让局域网其他设备访问

Ollama 仅允许本机访问,若需局域网其他设备调用,需修改配置让其监听全网地址:

jsvim /etc/systemd/system/ollama.service

修改后如下:

js[Unit]

Description=Ollama Service

After=network-online.target

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

ExecStart=/usr/local/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="PATH=/root/.local/bin:/root/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin"

[Install]

WantedBy=default.target

然后重启服务

jssudo systemctl daemon-reload sudo systemctl restart ollama

之后局域网设备可通过 http://你的LinuxIP:11434 调用 API(例如用 curl 或 Web 界面)

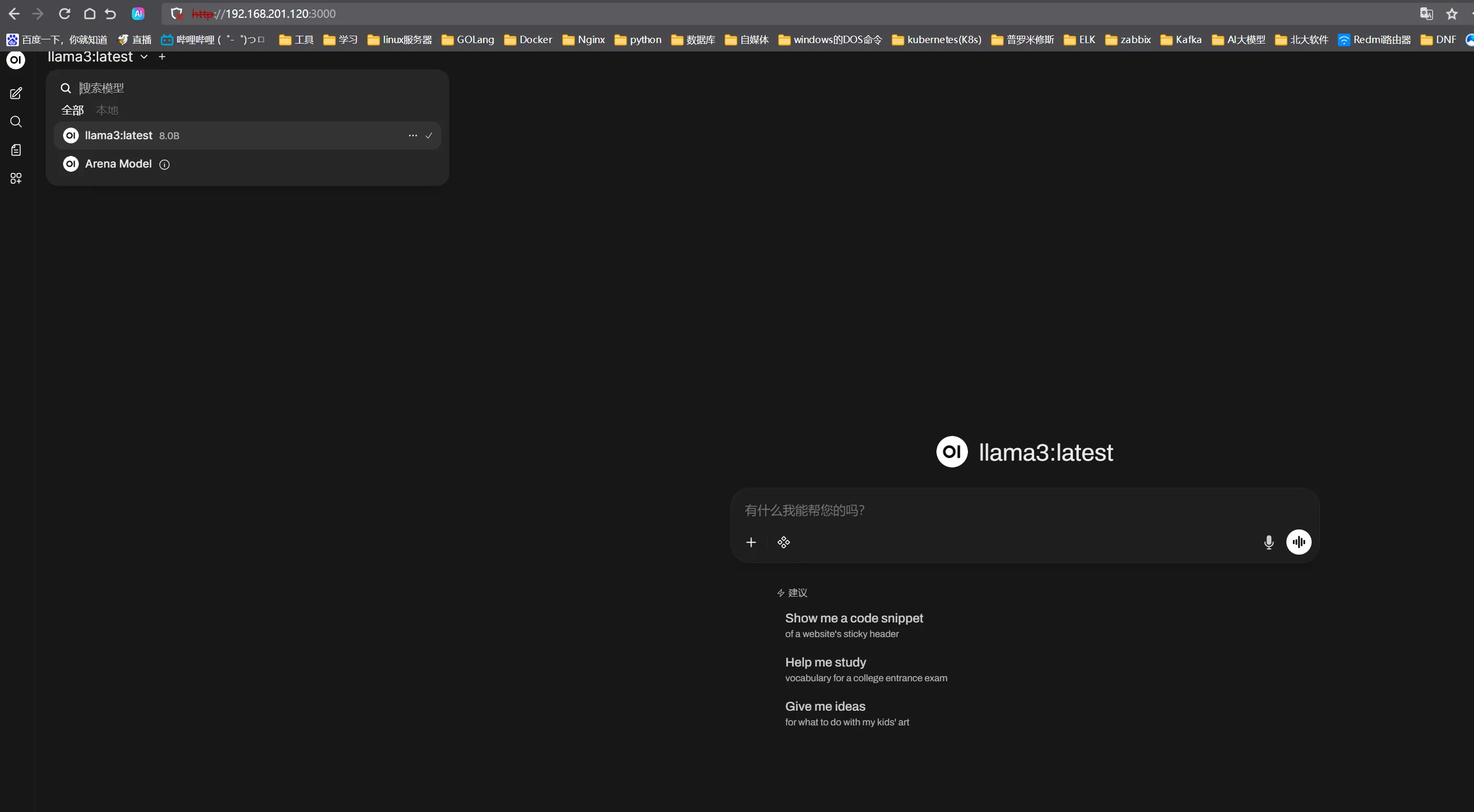

然后安装docker 运行一个web界面,启动后访问IP+3000

jsdocker run -d -p 3000:8080 \

-e OLLAMA_BASE_URL=http://192.168.201.120:11434 \

-v open-webui:/app/backend/data \

--name open-webui \

ghcr.io/open-webui/open-webui:main

docker-compose方式

ymlversion: '3.8'

services:

open-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: open-webui # 容器名称,与原命令一致

ports:

- "3000:8080" # 端口映射,主机3000端口映射到容器8080端口

environment:

- OLLAMA_BASE_URL=http://192.168.201.120:11434 # Ollama服务地址,与原命令一致

volumes:

- open-webui:/app/backend/data # 数据卷挂载,持久化存储对话历史、配置等

restart: always # 容器退出时自动重启(可选,推荐加上)

networks:

- open-webui-network # 独立网络,避免与其他容器冲突

volumes:

open-webui: # 声明数据卷,确保数据持久化

networks:

open-webui-network: # 声明网络

driver: bridge

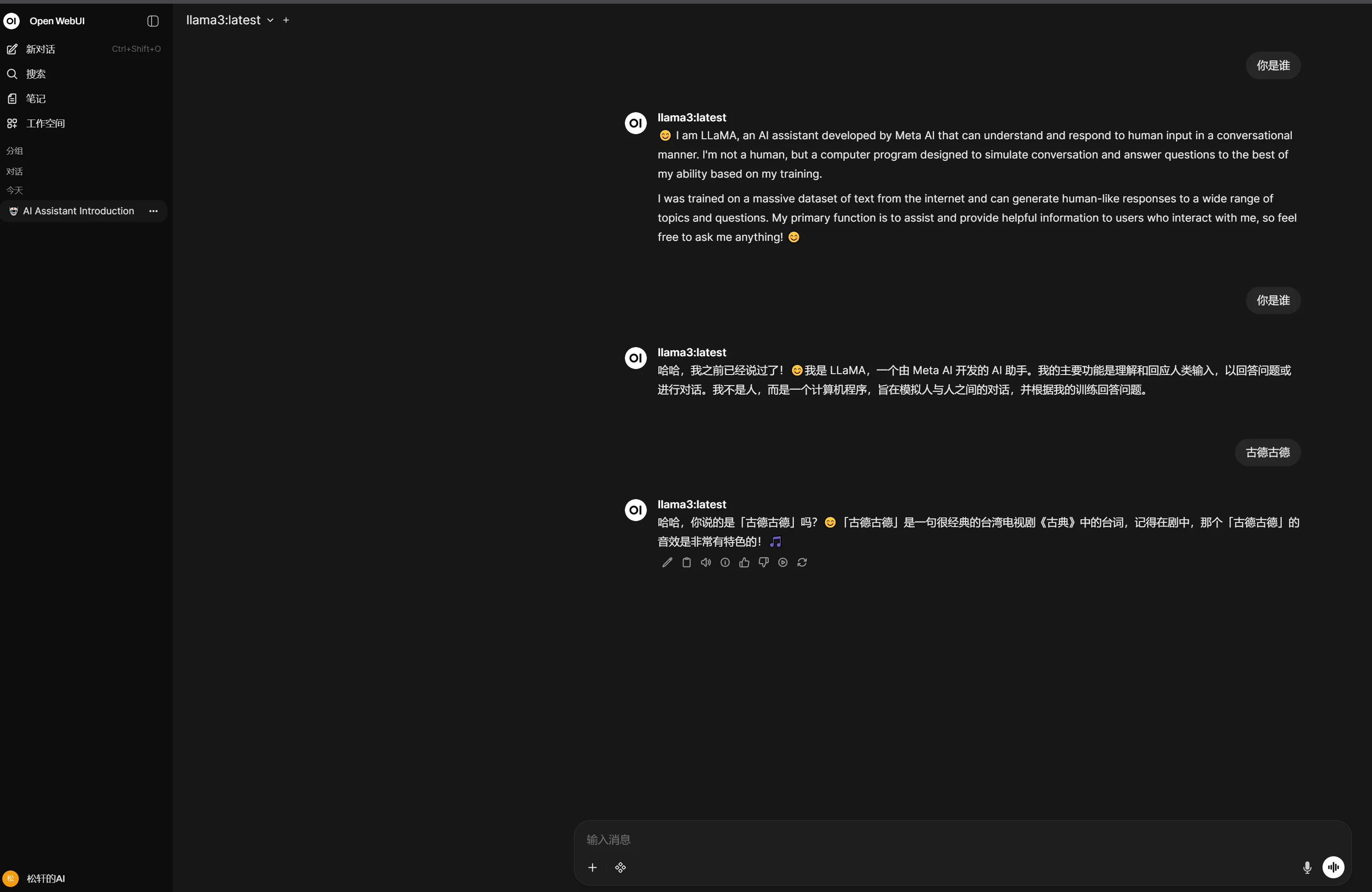

这样就可以使用自己的AI啦

本文作者:松轩(^U^)

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!

目录