请注意,本文编写于 45 天前,最后修改于 45 天前,其中某些信息可能已经过时。

目录

一、Ollama介绍

Ollama 是一个轻量级、开源的工具,主要用于在本地设备(如电脑、服务器)上快速部署、运行和管理大语言模型(LLM),无需复杂的配置,适合开发者和普通用户快速体验开源模型。

- 它的核心特点包括:

- 简单易用:通过命令行即可操作,支持一行命令下载、启动模型(如 ollama run llama2 即可运行 LLaMA 2 模型),无需手动处理模型文件、依赖配置等复杂步骤。

- 支持主流开源模型:内置了对多种热门开源大模型的支持,如 LLaMA 2、Mistral、Phi-2、Gemini 开源版、Qwen(通义千问)等,用户可直接调用,也支持自定义模型。

- 本地化运行:模型完全在本地设备运行,数据不经过第三方服务器,适合对隐私敏感的场景(如处理本地文档、内部数据等)。

- 轻量化设计:体积小,资源占用相对可控,普通电脑(甚至笔记本)也能运行中小型模型(如 7B 参数模型),同时支持 GPU 加速(需显卡支持)以提升性能。

- 扩展能力:提供 API 接口,方便开发者将本地模型集成到自己的应用、脚本或工具中(如结合 LangChain 构建 RAG 系统、开发聊天机器人等)。

二、Ollama安装

官网下载连接:https://ollama.com/download/windows

网速慢自己翻墙

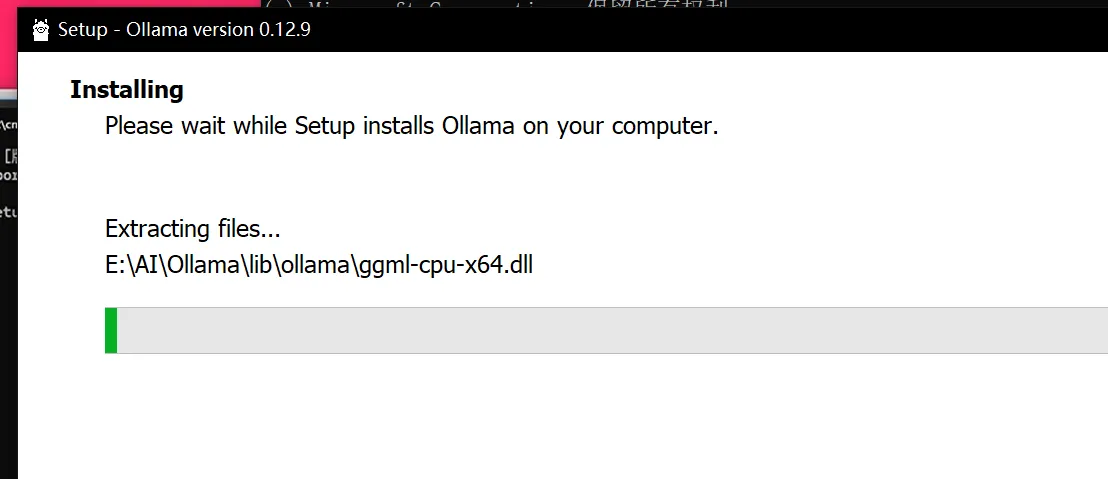

下载好安装包后,自己丢到一个其他盘去,不然安装是默认C盘无法修改的

然后启动CMD命令窗口

然后启动CMD命令窗口

jsOllamaSetup.exe /DIR=E:\AI\Ollama

回车然后就会装在该目录下。

回车然后就会装在该目录下。

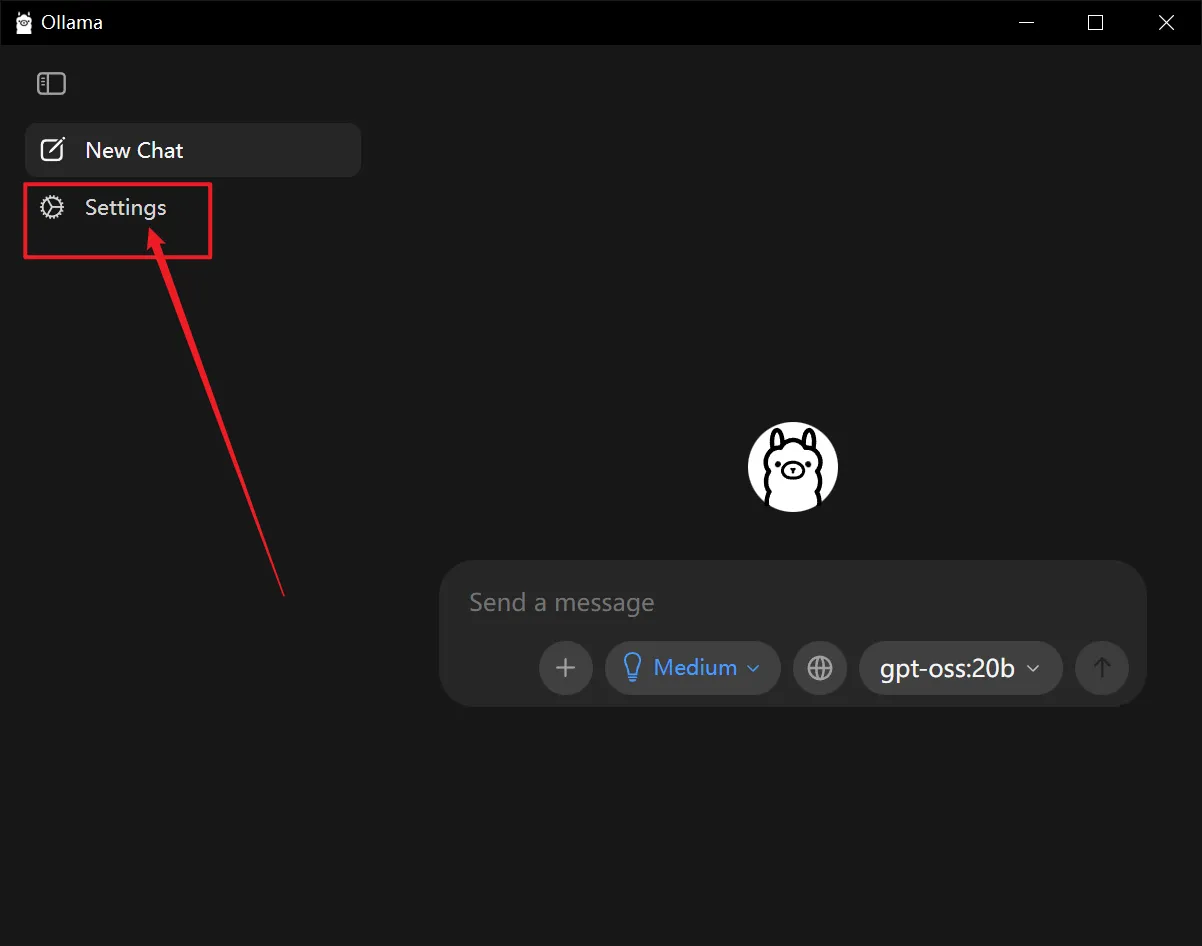

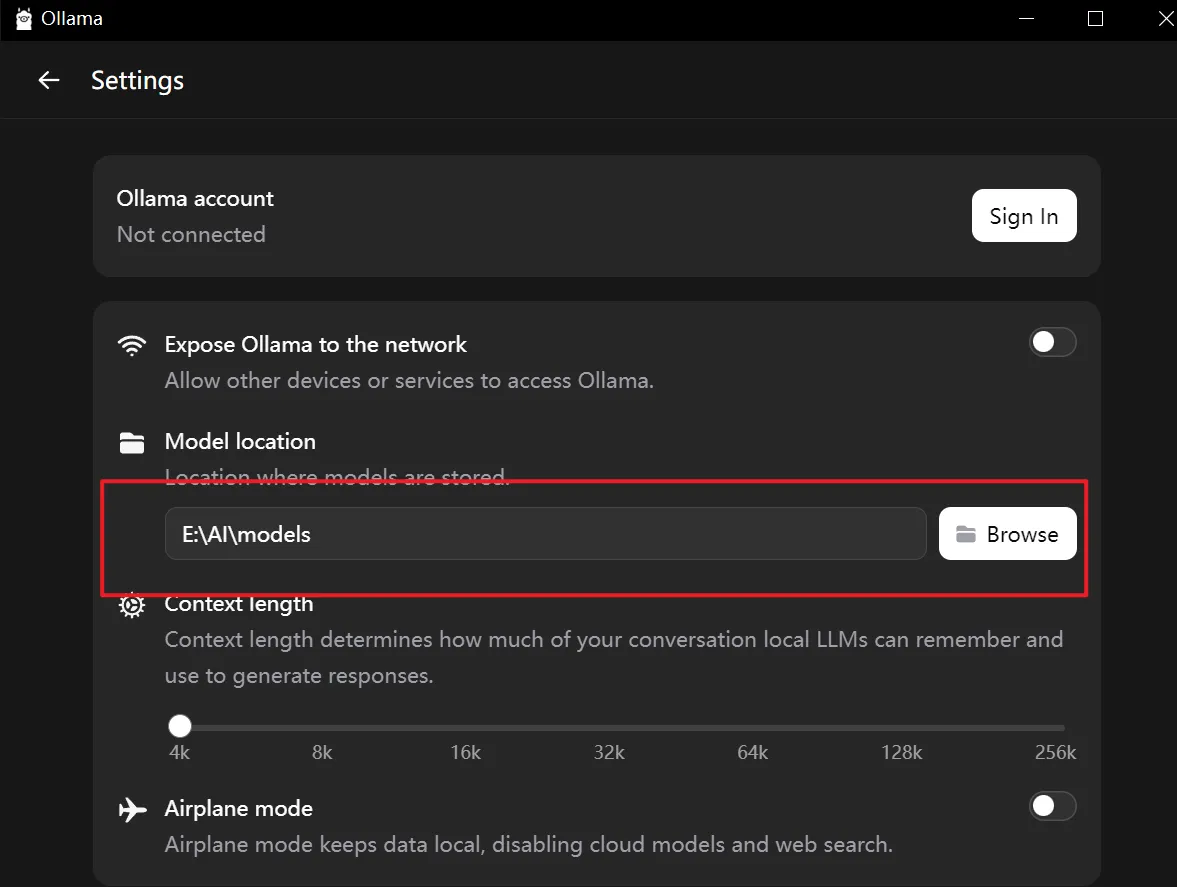

安装好后,更改模型的路径

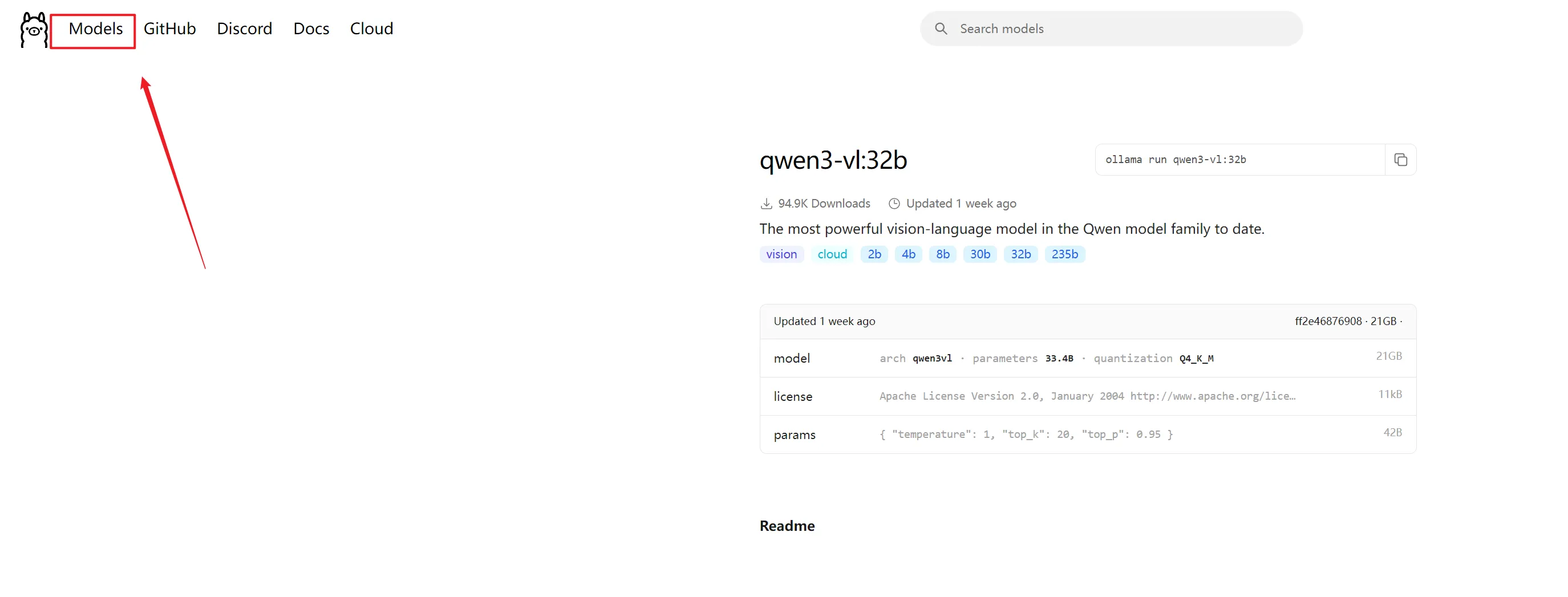

三、安装大模型

可以去官网这里找你要下载安装的大模型

安装好后即可使用了

四、命令

txt基础管理命令 ollama serve:启动 Ollama 服务器(后台运行时需要保持该进程) ollama list:列出本地已下载的所有模型 ollama pull <模型名>:下载指定模型(如 ollama pull llama3) ollama push <模型名>:将本地模型推送到远程仓库(需配置仓库) ollama rm <模型名>:删除本地指定模型 ollama cp <源模型> <目标模型>:复制模型(可用于创建模型副本或重命名) 模型运行命令 ollama run <模型名>:交互式运行指定模型(进入对话模式) ollama run <模型名> "你的问题":非交互式运行模型并直接获取指定问题的答案 模型信息命令 ollama show <模型名>:查看指定模型的详细信息(如参数、<模型名>`:查看指定模型的详细信息(如参数、大小等) ollama show <模型名> --modelfile:查看模型的 Modelfile 配置内容 自定义模型命令 ollama create <自定义模型名> -f <Modelfile路径>:根据 Modelfile 创建自定义模型 ollama inspect <模型名>:查看模型的详细配置和元数据 服务器控制命令 ollama stop:停止 Ollama 服务器(部分环境适用) ollama restart:重启 Ollama 服务器(部分环境适用) 使用时可以通过 ollama help 查看所有命令的完整列表,或通过 ollama <命令> --help 查看具体命令的详细用法(如 ollama run --help)。

本文作者:松轩(^U^)

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!

目录